Nueva imagen de https://www.instagram.com/nachosmooth/

Los colores

Hasta la noche es #hawaiianfriday

Nueva imagen de https://www.instagram.com/nachosmooth/

Hasta la noche es #hawaiianfriday

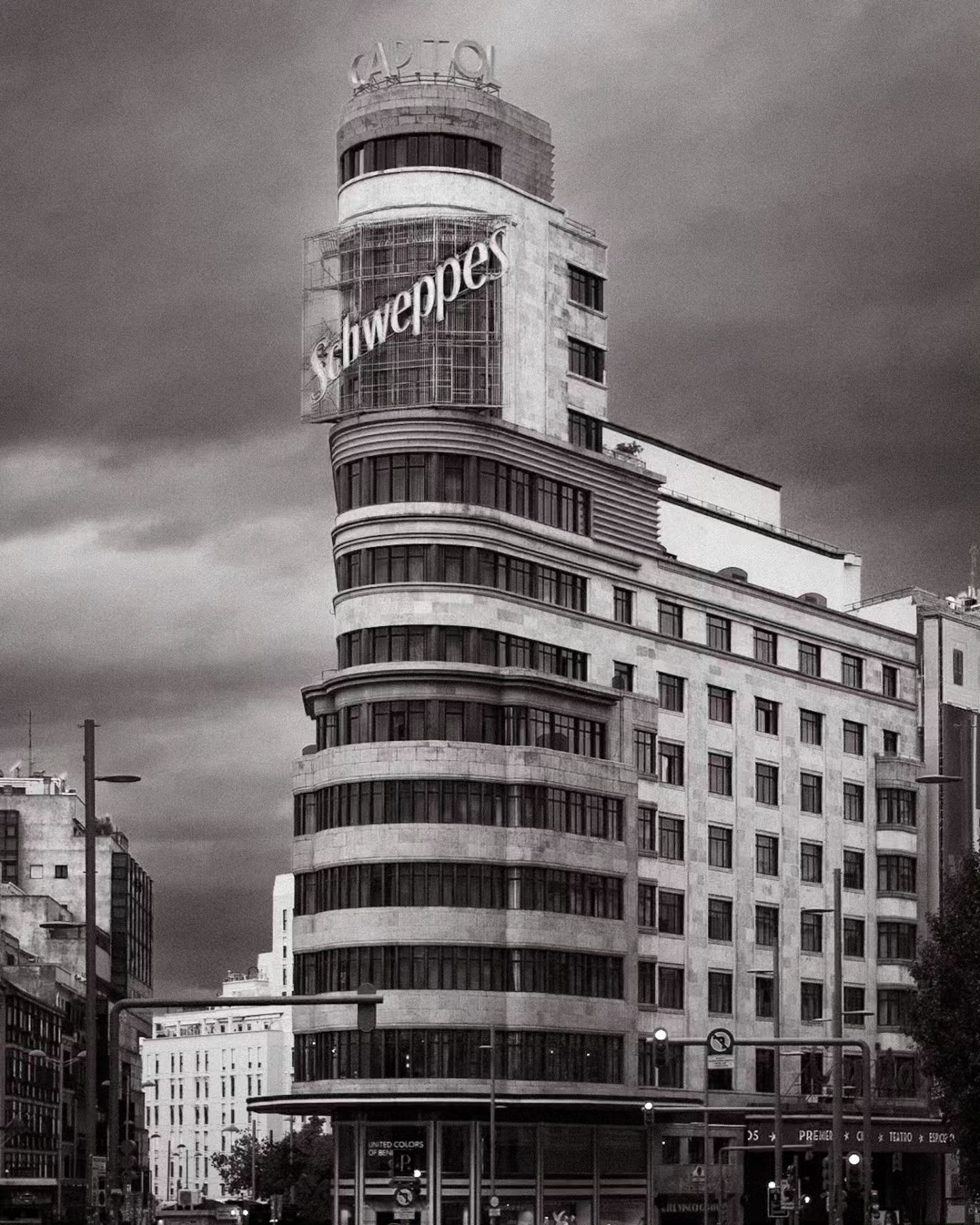

Una foto que he hecho muchas veces, pero hoy un poco más oscura#bw #bnw #bnw_legit #loves_bnw #monoart #blackandwhite #bnw_life #_bnwart_ #monochrome #lumixg9 #microfourthirds #gominimalmag #spanishexplorers

Nueva imagen de https://www.instagram.com/nachosmooth/

Una foto que he hecho muchas veces, pero hoy un poco más oscura#bw #bnw #bnw_legit #loves_bnw #monoart #blackandwhite #bnw_life #_bnwart_ #monochrome #lumixg9 #microfourthirds #gominimalmag #spanishexplorers

No nos olvidemos, que es #hawaiianfriday y no se perdona ni unoCamisa de @anabuenonature

Nueva imagen de https://www.instagram.com/nachosmooth/

No nos olvidemos, que es #hawaiianfriday y no se perdona ni unoCamisa de @anabuenonature

Dedicado a todos los modernos de pueblo y hipsters que piden un flat white con leche de avena y dos cucharadas de azucar a @carettix en @faradaymadrid ¡Arriba el expreso!¡La tortilla de patatas con cebolla!¡El bocadillo de chorizo!¡Los torreznos!¡El queso de oveja!

Nueva imagen de https://www.instagram.com/nachosmooth/

Dedicado a todos los modernos de pueblo y hipsters que piden un flat white con leche de avena y dos cucharadas de azucar a @carettix en @faradaymadrid ¡Arriba el expreso!¡La tortilla de patatas con cebolla!¡El bocadillo de chorizo!¡Los torreznos!¡El queso de oveja!

Nueva imagen de https://www.instagram.com/nachosmooth/

Dedicado a todos los modernos de pueblo y hipsters que piden un flat white con leche de avena y dos cucharadas de azucar a @carettix en @faradaymadrid ¡Arriba el expreso!¡La tortilla de patatas con cebolla!¡El bocadillo de chorizo!¡Los torreznos!¡El queso de oveja!